Тексты, созданные с помощью ИИ, стали частью учебной и рабочей рутины. Студенты пишут курсовые и дипломы с подсказками нейросетей, компании готовят отчёты и презентации в генераторах. На первый взгляд это ускоряет процесс, но вопрос оригинальности выходит на первый план.

Университеты и работодатели хотят быть уверены в достоверности работы. Речь идёт не только о плагиате в классическом смысле, но и об ответственности за содержание. Если текст создавал человек, он понимает и может защитить написанное. Если это результат генерации — возникает риск ошибок и подделок, за которые некому отвечать.

Поэтому растут требования к прозрачности. Вузы внедряют дополнительные модули к системам антиплагиата. Например, в НИУ ВШЭ с января 2024 года работает встроенный плагин для распознавания сгенерированных текстов. Компании тоже начинают использовать такие алгоритмы, особенно при приёме сотрудников или оценке подрядчиков.

Ошибки системы возможны: детекторы выдают ложные срабатывания. Но регламенты всё равно ужесточаются, потому что потребность в защите от недостоверных материалов перевешивает риск.

❗ Декларация использования ИИ снижает риск санкций — скрытие чаще всего наказывается.

Что происходит на рынке: как меняются политики вузов и компаний

Университеты и работодатели пересматривают подход к контролю текстов. Если раньше основным барьером был антиплагиат, то теперь на первый план выходят модули для распознавания генеративных материалов. Сервисы дополняют классическую проверку на плагиат отдельными блоками, которые ищут следы машинной генерации.

В 2025 году Turnitin расширил отчёт о сходстве: теперь система показывает не только заимствования, но и вероятность использования нейросети. В российских вузах к привычным программам добавляют AI-модули, а часть экзаменов снова проводят в устной форме. Причина проста — преподавателям важно убедиться, что студент действительно владеет материалом, а не только умеет подставлять запросы в генератор.

Компании идут тем же путём. При приёме на работу или оценке подрядчиков HR-службы проверяют тексты и отчёты с помощью нескольких инструментов. Проблема в том, что детекторы часто дают спорные результаты. Одни и те же материалы разные сервисы могут оценить противоположно: от «написано человеком» до «100% ИИ». Тесты, проведённые профильными изданиями, подтверждают: разброс точности велик, и полагаться на один алгоритм рискованно.

Типовые требования в РФ и за рубежом

Чтобы снизить риски, организации формируют собственные правила. В них обычно встречаются такие пункты:

- обязательная декларация об использовании ИИ при подготовке работы;

- хранение черновиков и версий документа;

- возможность устного зачёта или защиты проекта;

- пороговые значения для отчётов детекторов (например, при вероятности выше 70% требуется дополнительная проверка);

- право на апелляцию и повторное рассмотрение;

- назначение ответственных за процедуру и прозрачный протокол.

Системы ИИ-детекции становятся частью стандартных процедур. Но решает не только технология — важнее регламент и то, как именно организация работает с результатами.

Проверка текста на искусственный интеллект: что реально работает в 2025

В 2025 году простого запуска одного сервиса недостаточно. Технологии AI развиваются быстро, а вместе с ними растёт и сложность выявления машинной генерации. Чтобы понять, кем созданы тексты, нужен комбинированный подход. Он включает технические инструменты, проверку фактов и анализ стиля.

Рабочая схема строится из нескольких элементов:

- использование сразу нескольких детекторов, а не одного;

- ручная сверка данных и источников;

- анализ языка: ритм, структура, повторяемость;

- контроль версий — история правок и черновиков.

Такой набор даёт больше шансов на объективную оценку. Даже самые известные сервисы ошибаются: в одних случаях они фиксируют «машинный след» там, где его нет, а в других — пропускают явный ИИ-текст.

AI детектор текста: как читать метрики и репорты

Многие алгоритмы показывают проценты «вероятности ИИ». Это не приговор. Такие цифры означают только вероятность, основанную на статистике. Сервисы вроде Turnitin или GPTZero сами предупреждают: показатели — ориентир, а не доказательство.

Ошибки возможны. Один и тот же документ может получить 20% или 80% «машинного следа» в разных системах. Поэтому важно использовать несколько инструментов и сравнивать их выводы.

👉 Используйте 2–3 инструмента и ищите совпадающие сигналы, а не один процент.

Проверка на следы ии: признаки и ограничения

Детекторы анализируют структуру и стиль. Среди признаков, которые часто выдают нейросети:

- ровный ритм предложений и однообразная длина;

- слишком «гладкий» текст без оговорок и отклонений;

- ссылки на материалы, которых не существует;

- подмена терминов или неверные даты.

Но такие признаки ненадёжны. Алгоритмы путаются в смешанных документах, где есть и человеческие, и сгенерированные части. Известны случаи, когда инструмент метил эссе студента как «полностью искусственное», хотя работа была оригинальной.

❗Запомните: детекторы дают вероятность, а не окончательный вердикт.

Определить текст, написанный нейросетью: рабочая комбинация проверок

Лучше всего работает пошаговый процесс:

- Прогон через несколько детекторов и сопоставление выводов.

- Проверка фактов, ссылок и дат — генераторы часто подсовывают несуществующие материалы.

- Сравнение черновиков и истории редактирования. Если у автора есть промежуточные версии, это сильный аргумент.

- Краткая устная защита. Человек может пояснить ход мыслей, нейросеть — нет.

Сравнительные исследования показывают: ни один инструмент не даёт стопроцентной гарантии. Но комбинация методов позволяет существенно снизить риск ошибки.

А если задача сложнее — нужен текст с нуля и без следов ИИ, стоит обратиться к опытным авторам. На бирже фриланса Work24 можно заказать материалы, написанные специалистами, которые учитывают требования уникальности и проходят проверки.

Популярные детекторы ИИ-текста на русском языке

Для практической работы можно использовать онлайн-сервисы, доступные на русском:

- retext.ai — подсвечивает фрагменты и показывает вероятность генерации.

- Isgen.ai — анализирует GPT-4, ChatGPT, Claude, Gemini; оценивает «машинность» текста.

- Smodin — поддерживает русский язык, работает с файлами до 5 000 символов.

- NeuralWriter — бесплатный детектор для статей, эссе и заметок.

- RewriteGuru — бесплатный инструмент, показывает процент «машинного» текста.

- GigaCheck (Сбер) — отечественный сервис для проверки на ИИ-след, ориентирован на русский язык.

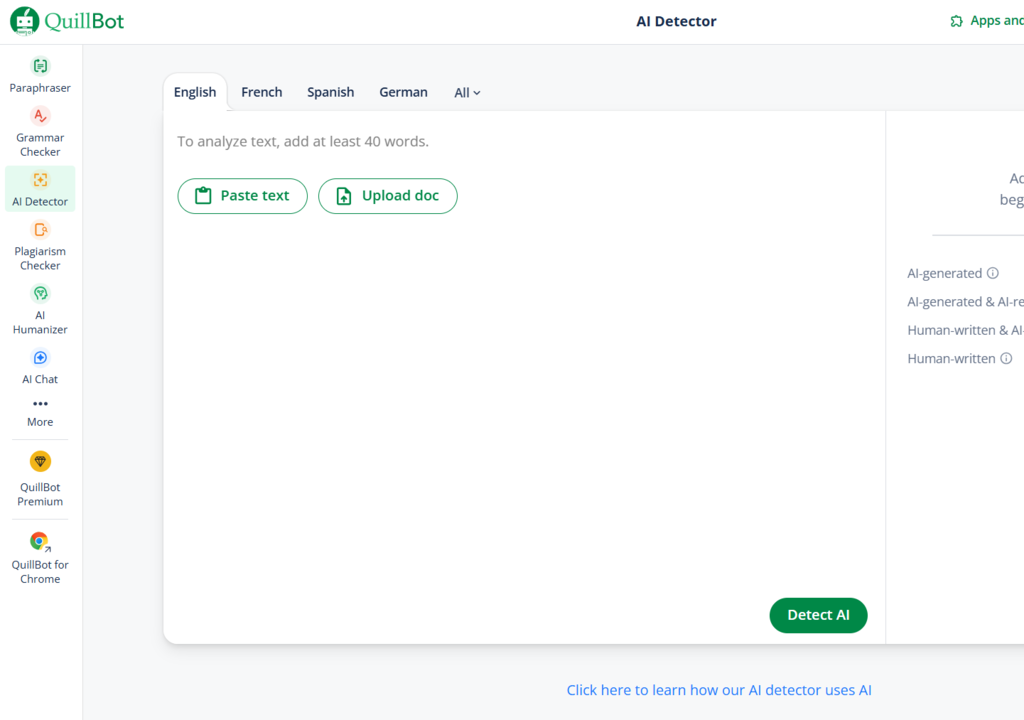

- QuillBot — определяет ИИ-контент, различает смешанные и полностью машинные тексты.

Ложные срабатывания: как снизить риск и не наказать автора зря

Алгоритмы часто ошибаются. Детекторы могут принять нормальный текст за машинный или наоборот — пропустить нейросетевую работу. Исследования показывают, что уровень ложных срабатываний у популярных сервисов вроде Originality.ai может доходить до 15–20%. Это значит, что каждый пятый документ рискует быть отмечен ошибочно.

Причины разные. Нейросети научились имитировать живой стиль, а детекторы, наоборот, «видят» машинный след там, где его нет. Особенно часто ошибки возникают в коротких текстах или в материалах с большим числом фактов и цифр. Отдельный риск — подделка источников: генератор может сослаться на несуществующую публикацию, и тогда даже качественный стиль вводит проверяющих в заблуждение.

Чтобы снизить риск, нужно выстроить процедуру повторной оценки. Одного отчёта недостаточно. Если система пометила работу как подозрительную, стоит подключить второй инструмент, попросить автора предоставить черновики и проверить факты вручную. Это дольше, но честнее.

❗ Не решайте по одному скрину — требуйте черновики и историю правок.

Процедура апелляции: что должен уметь студент/сотрудник

Ошибки возможны, поэтому важно иметь понятный механизм защиты. Автор должен доказать, что текст принадлежит ему. Для этого подойдут:

- сохранённые версии файлов с метками времени;

- заметки и наброски, сделанные в процессе;

- переписка с коллегами или руководителем, где обсуждаются отдельные части работы;

- комментарии и исправления от преподавателя или редактора.

Такой набор аргументов помогает показать, что документ — результат настоящей работы, а не просто выгрузка из генератора.

Техническая сторона: как работают алгоритмы

Алгоритмы ИИ-детекторов ищут статистические сигналы в тексте. Главный признак — уровень перплексии, то есть «неожиданность» слов для модели. У машинных текстов она часто ниже, предложения слишком предсказуемы. Дополнительно анализируют энтропию — разнообразие структуры и словаря.

Есть и другие маркеры. Алгоритмы проверяют синтаксис: равномерная длина предложений, повторяющиеся обороты, отсутствие оговорок. Иногда ищут «водяные знаки» — скрытые метки, встроенные в генераторы. Но пока это слабая защита: редактирование человеком легко стирает такие следы.

Исследования показывают: на смешанных текстах точность падает. Если автор переписал куски, добавил примеры или поменял стиль, вероятность ошибки у детектора резко растёт. Поэтому выводы всегда носят вероятностный характер.

🔬 Детектор — вероятностная модель, а не полиграф.

Многодетекторный стек

Оптимальное решение — комбинировать разные классы инструментов. Каждый из них «видит» только часть картины:

- академические сервисы, встроенные в системы проверки заимствований;

- редакторские утилиты, которые подсвечивают стиль и повторы;

- корпоративные продукты с расширенной аналитикой и логированием.

Вместе они закрывают до 80% кейсов. Такой подход снижает риск ложных срабатываний и делает выводы более обоснованными.

Один алгоритм не способен гарантировать точность, но связка нескольких сервисов и ручного анализа даёт рабочий результат.

Ошибки и как их избежать

Даже при использовании сложных инструментов легко допустить просчёты. Чаще всего проблемы связаны не с самим алгоритмом, а с тем, как организации трактуют результаты.

Вот типичные ошибки:

- доверять одному сервису и его «процентику»;

- не сверять выводы разных систем;

- игнорировать историю версий документа;

- не проверять ссылки и даты, оставленные автором;

- считать отчёт окончательным без интервью или устной защиты;

- трактовать серую зону (50–70%) как автоматическую вину;

- хранить отчёты локально, без доступа к команде;

- не прописывать регламент действий при спорных случаях;

- превращать процесс в гонку за минимальным процентом;

- использовать систему без обучения сотрудников;

- не фиксировать результаты повторных проверок;

- наказывать автора сразу, без апелляции;

- закрывать глаза на возможность человеческой ошибки в отчёте.

🚫 Не гоняйтесь за «0% AI» — это не цель, цель — достоверность.

Заключение и требования к внедрению

Вопрос работы с ИИ-контентом уже нельзя откладывать. Университеты и компании формируют свои требования, чтобы защитить процесс обучения и рабочие проекты. Отдельные сбои алгоритмов не отменяют сути: контроль нужен, иначе доверие к результатам падает.

Надёжная система строится по шагам: есть политика, прописаны декларации об использовании ИИ, заданы пороги для отчётов, настроен стек инструментов. Версии документов хранятся, рецензенты понимают, как читать отчёты, а апелляция доступна каждому студенту или сотруднику.

Детектор — это лишь инструмент. Прозрачные правила и ответственность людей делают систему устойчивой и справедливой.

Комментарии